[nextpage title=”Introduzione”]Dopo un’attesa fatta di rinvii, aspettative iperboliche e lotte fra fanboy, finalmente Vega è tra noi. O meglio, tra gli invitati all’evento SIGGRAPH in California e fra i partecipanti a LTX2017 di LinusTechTips.

Le schede saranno messe in vendita il 14 agosto 2017 in tre modelli, che riporto in ordine decrescente di prezzo (e prestazioni?): RX Vega 64 Liquid (699$) , RX Vega 64 (499$) e RX Vega 56 (399$).

I dati delle rispettive prestazioni sono stati offerti da AMD all’evento e non sono ancora disponibili recensioni indipendenti e risultati di benchmarks, pertanto i risultati vanno presi cum grano salis, per scomodare Plinio il Vecchio, ma sembrano promettere una diretta competizione fra la RX Vega 64 e GTX 1080 di Nvidia in molti giochi.

Con le architetture Polaris della serie 400 e 500 di AMD abbiamo già visto che l’enfasi della squadra rossa sulle computazioni asincrone ed il puntare su nuove API (come la defunta Mantle e la poco diffusa Vulkan) ha pagato dividendi disomogenei, data la prevalenza massiccia di DX11 come API per molti giochi che ancora premia la frequenza e densità dei CUDA di Nvidia. Con Vega però questa dinamica potrebbe cambiare, perché questa volta AMD non offre solamente innovazioni ‘esotiche’ e poco diffuse, per quanto lungimiranti, ma anche prestazioni e specifiche competitive, almeno su carta.

[nextpage title=”Aspettative e problemi”]

Partendo dai dati che sono stati rilevati per Vega FE, la parentela tra la versione semiprofessionale e quella gaming RX è evidente e di conseguenza una analisi comparata fra Vega 64 e Vega FE fa risaltare il lavoro di ottimizzazione messo in atto da AMD per offrire al mercato una scheda gaming competitiva.

La scheda semiprofessionale non aveva entusiasmato per le sue prestazioni gaming, poste tra una 1070 ed una 1080, ma ad un prezzo molto superiore. Aveva fatto invece trasalire per l’esosa richiesta di alimentazione e per la modesta differenza in termini di stabilità di clock fra la versione ad aria e quella a liquido. Il tutto coronato da un prezzo da scheda per uso professionale, le cui concorrenti erano quindi o le Quadro o la Titan Xp, più potenti, efficienti ed ottimizzate per carichi operativi di natura professionale (Deep Learning in testa alla classifica).

Queste premesse non avevano fatto ben sperare per RX Vega 64, in quanto l’architettura di Vega era ormai svelata e non si potevano di certo aspettare miracoli. I sogni di avere tra le mani una 1080Ti killer sono svaniti davanti ai dati dei benchmarks della Frontier Edition e pertanto la chiave del successo di Vega sembrava risiedere interamente nella sua collocazione di prezzo rispetto alla competizione.

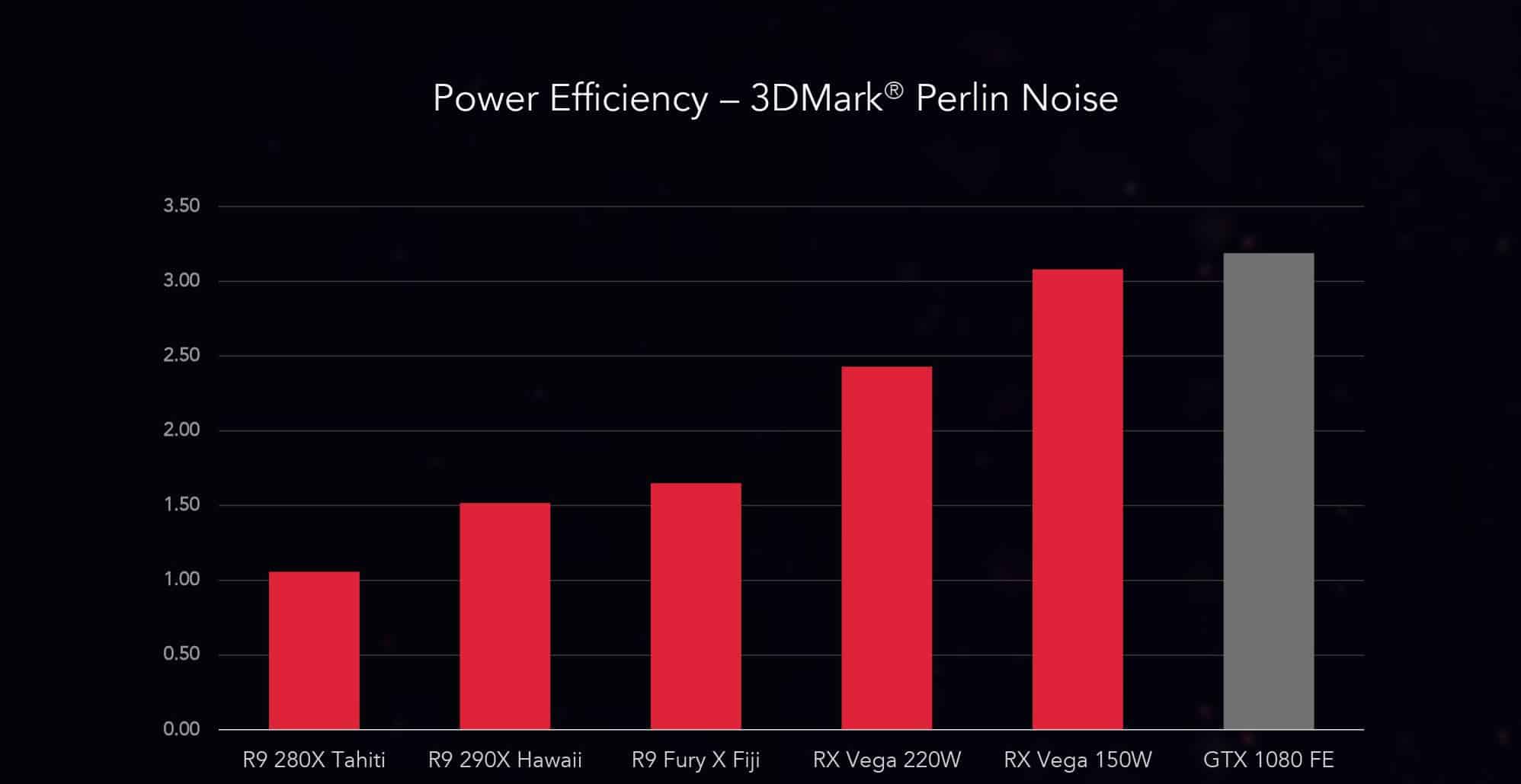

In questo AMD sembra aver fatto una scelta oculata, ma ha anche sorpreso con una serie di miglioramenti ed ottimizzazioni della propria architettura tali da regalare qualche fps in più e qualche Watt in meno, sebbene si stia sempre parlando di schede più affamate di corrente di Pascal ed il cui ritorno di fps/watt sembra comunque seguire il trend della Frontier Edition.

A parità di specifiche fra la versione raffreddata a liquido e quella raffreddata ad aria delle due RX Vega 64, il consumo energetico passa da 290W (GPU + board) a 350W (GPU + board + LC) per un salto in prestazioni e stabilità di clock che su Vega FE era risultato minimo. Peraltro questi dati non raccontano tutta la storia, in quanto la Vega FE raffreddata a liquido offriva sì un clock più stabile ed un margine di overclock, ma con un incremento di clock di solo il 7% il consumo totale della scheda saliva a 440W. Possiamo aspettarci un comportamento simile anche da RX Vega 64? Sembrerebbe probabile, ma bisogna aspettare i benchmarks.

AMD ha offerto due schede all’evento, la RX Vega 64 e, novità tutto sommato inattesa, la RX Vega 56. Vega 56 è una versione ‘ritagliata’ di Vega 64, meno esosa dal punto di vista energetico ed ad un prezzo da fascia media che potrebbe risultare davvero molto interessante, considerando l’ottimizzazione e la tecnologia di fondo messa in campo da Vega.

La RX Vega 64 contiene un singolo graphics engine, con 4 Asynchronous Compute Engines e 4 Geometry Engines che sono stati rivisti per questa specifica iterazione RX. RX Vega 64 è dotata di 64 Compute Units per un totale di 4096 Cores, ed ogni CU contiene 4 Texture Mapping Unit, per un totale quindi di 256 TMUs. La scheda avrà inoltre 64 renderer back-end responsabili della gestione della delta colour compression e color buffer compression. Come per la FE, questa scheda possiede 4MB di cache di secondo livello ed un interfaccia di memoria a 2048-bit.

La RX Vega 56, in quanto versione ridotta della 64, avrà a sua disposizione 3584 Cores, 56 CUs e 224TMUs.

In preparazione alla recensione che arriverà presto, cerchiamo di capire che cosa nasconde la copertura in alluminio (disponibile in edizione limitata) della nuova Vega.

Indice

Toggle[nextpage title=”High Bandwith Memory 2 (HBM2) e High Bandwith Cache Controller (HBCC)”]

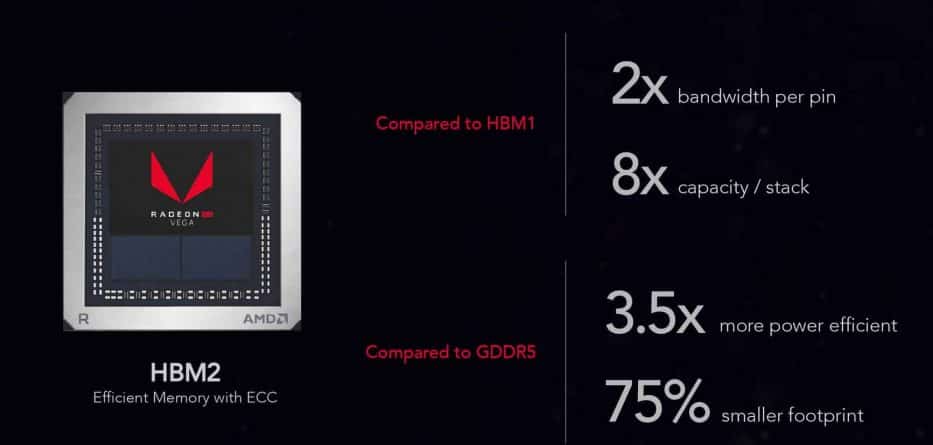

L’innovazione più evidente delle RX Vega rispetto alla competizione è certamente la scelta di utilizzare memoria HBM2, dotando le sue schede di 8GB di VRAM. AMD ha puntato sin dalle R9 Fury X su questa tecnologia di memoria, che permette la sovrapposizione dei chip in pile direttamente sull’interposer in silicio dove risiede la GPU, collegate tra loro da TSVs (through silicon vias), che aumenta la complessità costruttiva ma diminuisce sensibilmente la superficie richiesta per grandi capacità di memoria e teoricamente offrendo un throughput maggiore. Dove Nvidia ha scelto di utilizzare memoria tradizionale DDR5X e DDR5 per le proprie schede video per questioni economiche e di reperibilità, AMD ha optato per una soluzione innovativa e lungimirante, come è ormai il suo modus operandi.

Purtroppo questa scelta non aveva pagato molto per le R9, dove la bassa capacità e l’elevato costo di implementazione avevano oscurato l’eleganza tecnologica della scelta. La seconda generazione di HBM ha permesso di porre fino a 8 die per stack di memoria con 8GB di capacità per pacchetto ed ha permesso di raggiungere 256 GB/s di banda tramite canali da 1024bit. Specifiche impressionanti, che però richiedono un processo produttivo costoso e la disponibilità di HBM2 è stata molto limitata fra il 2016 ed il 2017 a causa proprio di Nvidia, che ha scelto questa tecnologia per le proprie schede Tesla. Il produttore principale di HBM2 è Samsung, la quale ha dovuto fra fronte agli ordini di Nvidia con stacks da 4Gb e solo da pochi mesi ha dato inizio ad una produzione di massa per stack da 8Gb (difatti su Vega RX vediamo installati 2 stacks da 4Gb, mentre sono 2 da 8Gb su Vega FE). [correzione del 3/08/2017 dell’autore]

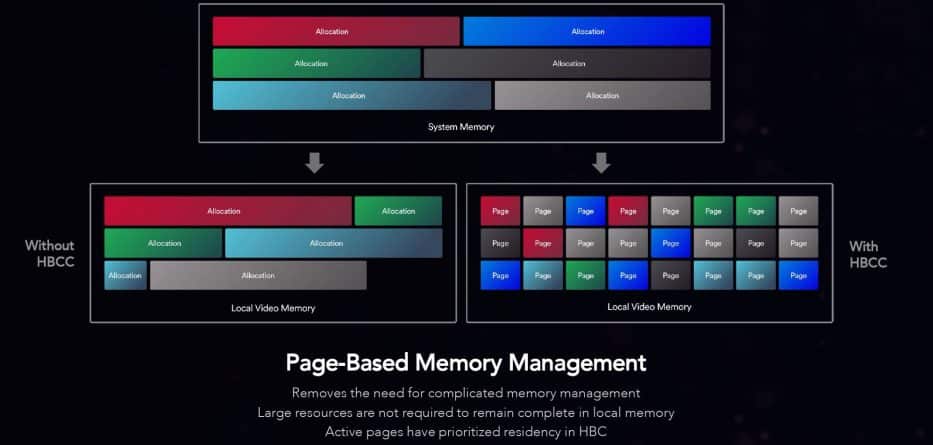

La scelta di AMD di confermare HBM2 come architettura di memoria è collegata al suo tentativo di generare una piccola rivoluzione nel modo di gestire gli assets di memoria video. Tramite l’uso di un controller specifico (HBCC) si vorrebbe velocizzare l’accesso agli assets eliminando complessi algoritmi di memory management utilizzando invece un sistema page-based della gestione della memoria, che permette l’accesso ai singoli ‘blocchi’ necessari per il render di una scena ad esempio, selezionando quali siano necessari nell’immediato e quali invece possano essere tenuti in una memoria più lenta. Con il rischio di risultare sempliciotti, l’idea è simile all’utilizzo in un PC di un SSD come disco di cache (à la Optane per intenderci) per velocizzare le applicazioni più frequentemente utilizzati ed i dati più richiesti, lasciando invece quelli meno richiesti in una archiviazione più lenta.

Questa innovazione si va a collegare con l’implementazione che AMD sta preparando per le sue schede workstation, che espanderanno il concetto utilizzando veri e propri banchi di flash come memoria ‘di sistema’ veloce combinata alla VRAM.

Le promesse di questa tecnologia sono davvero allettanti, ma quanto inciderà sulle prestazioni dei giochi è da vedere, visto che sicuramente richiederà una ottimizzazione anche dal lato dei developers.

[nextpage title=”Next Generation Compute Unit, il cuore di Vega”]

Vega 10 è una nuova architettura e su carta appare davvero poliedrica e capace di saper rispondere alle necessità sia dei giocatori che dei professionisti. Contrariamente ad Nvidia, che ha separato duramente con il discrimine della capacità di calcolo Single e Double Precision il proprio mercato gamer da quello prosumer, AMD ha deciso di offrire ai propri clienti entrambe la possibilità di affrontare operazioni FP32 e FP64 sulla stessa scheda, senza contare il continuato supporto 8bit e 16bit flottante.

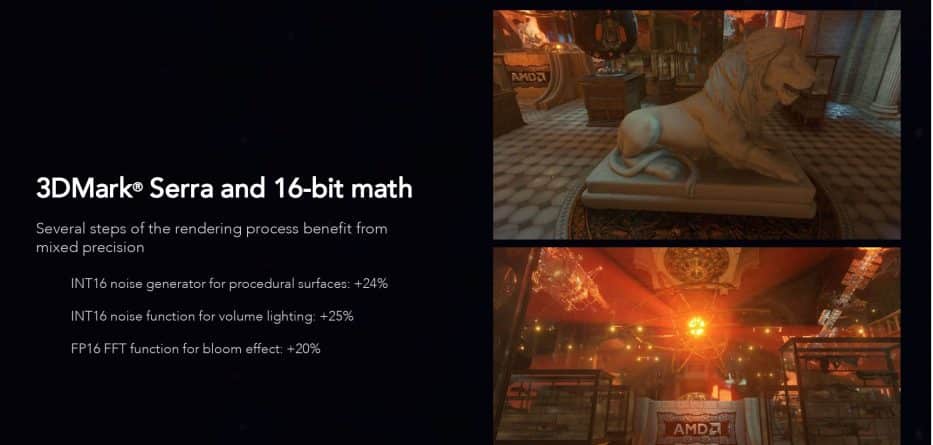

In Vega è stata introdotta la feature Rapid Packed Math, che sostanzialmente utilizza un calcolo a 16bit invece che uno a 32bit per applicazioni che non richiedono necessariamente tanta precisione per dare un risultato accettabile. L’esempio offerto sarebbe quello di un effetto luce in una scena di un gioco, dove una operazione svolta con una precisione a 16bit ed a 32bit non offre nessuna significante differenza in termini di resa grafica, ma richiede molte meno risorse e lascia quindi più ‘spazio’ per ulteriori operazioni di calcolo, pare fino a 4 o 5 volte più operazioni per ciclo rispetto a Polaris. Tutto da verificare, ma sicuramente una prospettiva molto interessante.

Una nota, felice o dolente a seconda del vostro interesse nelle criptovalute, è che Vega supporterà oltre 40 nuovi Instruction Sets . Questo, unito alle maggiori Instructions Per Clock, permetterà hashrate superiori rispetto alla razziata Polaris, pertanto la penuria di GPU potrebbe vedere un altro picco. Ma AMD pare sia già corsa ai ripari con le offerte dei pacchetti sconto che spingerebbero all’acquisto di un intero sistema piuttosto che non solo della singola scheda, cosa che dovrebbe in teoria disincentivare l’acquisto per i minatori.

[nextpage title=”Supporto API e nuove tecnologie grafiche”]

AMD ha cercato per molto tempo di spingere nuove e più efficienti API rispetto a DirectX, che nella sua undicesima enumerazione domina da anni il mondo dei videogiochi. Nuove API vogliono dire nuove features, meno overhead, più efficienza ma anche molti più mal di testa per gli sviluppatori.

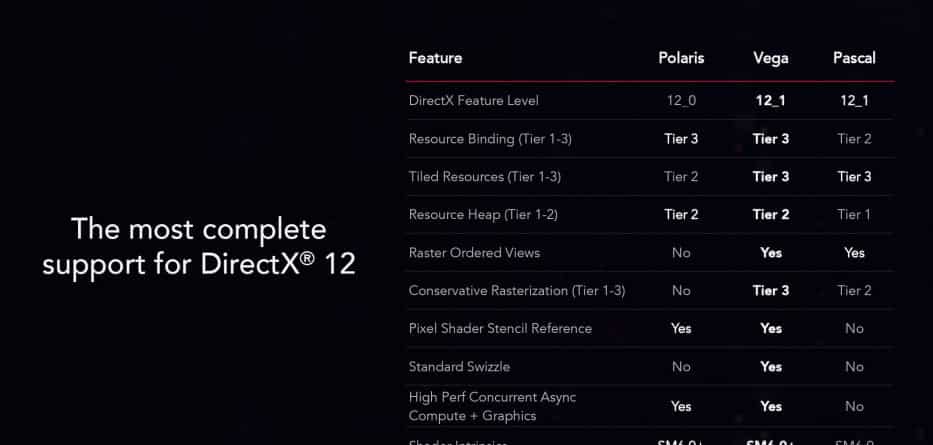

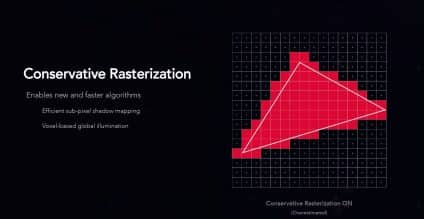

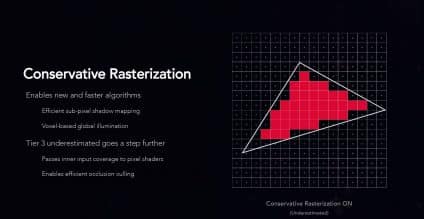

Con RX Vega AMD ha confermato la sua dedizione a questa via ed ha puntato ancora più pesantemente rispetto a Polaris (ed a Pascal) sulla implementazione di OpenGL, Vulkan e DirectX12.1. Garantendo il massimo supporto per i tier massimi delle varie feature di DX12.1 (resource bindig, tiled resources, reasoruce heap, raster ordered views, conservative rasterization, high performance async compute etc) Vega è la piattaforma grafica più avanzata e lungimirante disponibile sul mercato consumer al momento.

AMD ha riparato alla pecca di Vega FE, dove il motore di Tile Based Rasterization era disattivato tout court perché la sua ottimizzazione avrebbe ritardato il lancio sul mercato della scheda semiprofessionale. L’importanza di questa tecnologia non può essere sminuita, in quanto garantisce che tutti i pixels, anche quelli solo parzialmente coperti, siano rasterizzati invece che sampled. Le implicazioni di questa tecnologia, specialmente in VR, sono estremamente interessanti. Nvidia aveva attivato questa tecnologia già con Maxwell e ne aveva ribadita l’importanza anche in occasione del lancio di Pascal. Ora Vega supporta TBR in Direct3D 12, sia in modalità ‘overestimated’ che ‘underestimated’.

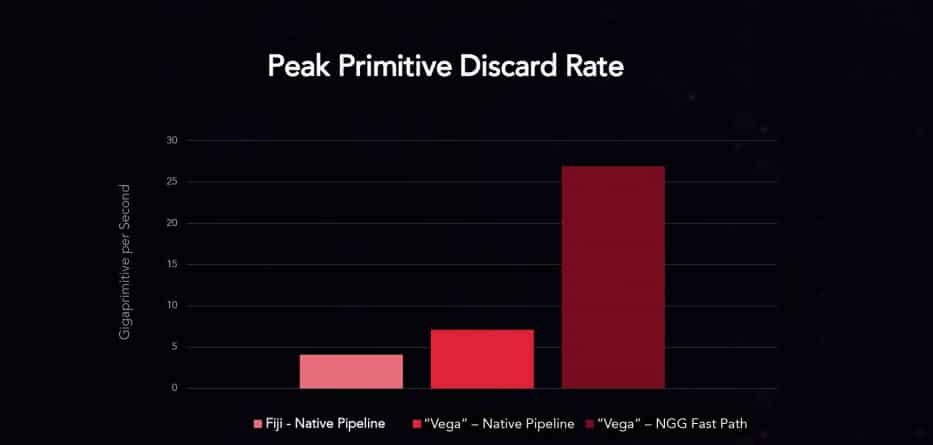

Un’altra innovazione di Vega è quella del Primitive Shader, il cui scopo è quello di aumentare l’output di picco della scheda selezionando cosa ‘presentare’ prima sullo schermo. L’esempio è quello della schermata di un videogioco, dove non è strettamente necessario rendere l’intero ambiente in continuazione, quando solo una porzione della scena è visibile sullo schermo, in quanto ci sono porzioni coperte da oggetti e ‘fuori-scena’. Elaborando solo i poligoni necessari Vega può offrire prestazioni migliori ed una maggiore efficienza, ma l’implementazione del Primitive Shader (che è supportato parzialmente sia da DX12 che da Vulkan) sta i developers, ma non c’è alcuna garanzia che venga utilizzato. Probabilmente per invogliarne l’implementazione, AMD ha marcato fortemente il fatto che Vega sia potenzialmente capace di scartare 5 volte più pixel ‘inutili’ tramite il suo NCG Fast Path (la pipeline operativa del Primitive Shader) rispetto a Polaris.

Ovviamente il supporto per computazione asincrona continua, avendo fatto guadagnare interessanti primati ad AMD con i giochi che lo implementavano (come Sniper Elite 4 e Ashes of the Singularity) e costringendo Nvidia a giocare alla rincorsa.

L’output di Vega dovrebbe consentire di connettere fino ad 1 pannello 5K/60Hz HDR oppure un pannello 4K/120Hz HDR o 3 pannelli 4K/60Hz HDR. Senza HDR Vega può supportare fino ad un pannello 8K/60Hz, 3 5K/60hz, 2 4K/120Hz e 6 4K/60Hz. Display Port 1.4 con Multi Stream Support, supporto HDR e HBR3, HDMI 2.0 con supporto HDR 12bit ed encoding 4:2:0.

Ovviamente è offerto il pieno supporto Free Sync, con l’aggiunta della tecnologia Low Framerate Compensation. Questa tecnologia dovrebbe permettere una esperienza di gioco fluida anche quando il framerate offerto dalla scheda è inferiore al minimo della implementazione Free Sync del proprio monitor (un problema che non affligge Gsync, che non ha un minimo operativo), specialmente se accoppiato ad Enhanced Sync, la versione di AMD di Fast Sync.

[nextpage title=”Problemi in sala macchine. Consumo e prestazioni”]

Una delle innovazioni principali delle RX Vega rispetto alle FE sembra essere nella ottimizzazione profonda della alimentazione delle schede, stando alle dichiarazioni dei rappresentanti di AMD. Sebbene i dettagli non siano ancora abbondanti, pare che il voltaggio operativo ottimale sia stato abbassato e che la frequenza di monitoraggio di questo valore sia stata alzata. Un dato confortante, dato che test svolti sulla Vega FE hanno dimostrato che era possibile ottenere un clock molto meno erratico abbassando il voltaggio del core, ottenendo così frametimes molto più consistenti e con delta fra 0.1% e 99% sensibilmente minori.

Una ultima importante modifica pare sia stata introdotta nel rapporto tra clock speed e power management, dove le schede RX Vega dovrebbero, grazie all’introduzione di nuovi power states, mantenere i boost clock promessi di 1546MHz per la 64, contrariamente a quanto avvenne con la Vega FE che invece promise un boost di 1600MHz, che però non mantenne stabilmente in nessuno dei test reali cui fu sottoposta. Vega FE aveva molte misure di risparmio energetico disattivate, che portavano quindi la scheda ad operare sì con meno restrizioni dell’alimentazione, ma a sprecare molta più energia, generando più calore e portando ad una frequenza di core clock più instabile. L’ottimizzazione sul fronte dell’alimentazione promessa da AMD per RX Vega sembra rifarsi molto a quella implementata sulla RX480, il che non è assolutamente una cosa negativa, ma i suoi benefici sono da provare con mano prima di gridare al miracolo. Per ora sembra si possa sperare in un consumo medio minore e più stabile.

C’è un aspetto della presentazione delle prestazioni di Vega che onestamente credo possa ben riassumere l’approccio quasi filosofico che AMD vorrebbe impartire al mondo del PC Gaming e che, onestamente, mi fa temere quello che uscirà dalle penne dei recensori più quotati del web quando avranno messo alla prova queste nuove schede. Sebbene siano stati offerti alcuni numeri sulle prestazioni reali di Vega in gioco, è stata enfatizzata ed offerta direttamente una nuova metodologia di valutazione delle prestazioni! Non più valori duri e misurabili di framerate, frametime, minimi e massimi, 0.1% e 99%, ma ‘smoothness’.

Il trionfo del soggettivo, del parziale, che sin dalla 480 è stato portato avanti a suo tempo anche dai rep della AIB Sapphire, dove si è pubblicamente sostenuta la inutilità di giocare ad impostazioni grafiche elevate perché tanto il giocatore in game non si può accorgere della differenza tra ultra e high, ma si accorge della maggiore fluidità della scena. Un punto portato ancora una volta in risalto in questa occasione, dove si è sostanzialmente mostrato che Vega offre una esperienza di gioco fluida (senza menzionare le impostazioni grafiche utilizzate, solo la risoluzione di 1440p ultrawide e 4K) se appaiato ad un monitor Free Sync in ‘6 giochi su 6’ piuttosto che una 1080, che senza gsync riesce comunque ad offrire una esperienza fluida (ma giocoforza con tearing) in 5 giochi su 6.

È naturale che con un pannello a refresh variabile l’esperienza sia più fluida, specialmente se a Free Sync è stato aggiunto un sistema di compensazione per picchi verso il basso (che siano forse scartati direttamente, garantendo pertanto minimi più alti?) ed il framerate medio offerto dalla scheda oscilli sempre all’interno di questo intervallo. Ma senza Free Sync? Il focalizzarsi sulla resa del 99% dei frame non racconta assolutamente tutta la storia dell’esperienza grafica in un videogame, specialmente perché se già i picchi verso il basso del 0.1% del frametime sono molto notevoli e possono fare la differenza fra una esperienza di gioco piacevole o meno, figuriamoci l’1% di frametime non annoverato nella statistica di AMD.

Questo atteggiamento non tiene conto della possibilità che un giocatore possa e voglia cambiare monitor un giorno, dove i valori dei frame e non della ‘fluidità soggettiva’ sono fondamentali per decidere se un aumento di risoluzione sia possibile e come scali in rapporto alle prestazioni. È fastidiosamente ‘applesco’ il voler determinare cosa il giocatore debba volere per il proprio ‘bene’ e cosa debba essere una esperienza soddisfacente.

Il tutto fa intravedere una specie di excusatio non petita da parte di AMD, che vuole forse mettere le mani avanti sui risultati dei benchmark che potrebbero dare un vantaggio di frame ancora a Nvidia, specialmente alla 1080 in titoli DX11 ormai affermati come metrica di prestazioni assolute.

[nextpage title=”Conclusioni (?)”]

AMD ha finalmente mostrato ufficialmente il suo prodotto ‘di rilancio’, unitamente a Threadripper non di meno, mostrando a chi avesse ancora dubbi che la competizione nel mondo del PC gaming e della componentistica per PC è ancora viva e vegeta. Nel mondo delle CPU sta avendo luogo un vero rinascimento, processori ad 8 e 6 core sono finalmente accessibili al mondo consumer per prezzi ragionevoli e su piattaforme accessibili ed il numero di core sta salendo vertiginosamente per le piattaforme high end desktop.

Possiamo aspettarci lo stesso da AMD anche nel campo delle GPU? Il fatto che molto probabilmente non ci troviamo davanti ad una 1080Ti in rosso è una delusione inattesa? Il carnet di innovazioni tecnologiche che AMD ha messo sul tavolo con Vega cambierà il modo in cui valuteremo l’esperienza videoludica?

L’appassionato di videogiochi e computer che è in me vorrebbe davvero sperarlo, ma dobbiamo aspettare dati concreti per esprimere un giudizio fattuale. Che, come ho detto nel paragrafo precedente, sembra qualcosa che AMD non vorrebbe facessimo. Ed è proprio questo atteggiamento che mi fa temere per Vega, non tanto perché non sia un prodotto valido (ci sono tutte le premesse perché sia un competitor a pieno titolo) ma quanto perché potrebbe non guadagnare il cuore degli appasionati. Dire ad un enthusiast, come noi, ‘Beh, ma cosa ti serve di più? Non ti basta questo?’ non è di solito foriera di reazioni composte. Per carità, è una osservazione altamente personale ed irrazionale, ma quando cerchi di vendere un pezzo di plastica e silicio per animare poligoni su uno schermo e chiedi una cifra considerevole IVA inclusa, devi anche saperla vendere al tuo pubblico. E per troppo tempo il pubblico di AMD è stato, giocoforza, quello più budget conscious, e non si possono applicare le stesse formule.

Conclusa questa critica psicologica, veniamo al dunque.

RX Vega soffre degli stessi problemi della Vega FE, ma ha ricevuto ottimizzazioni tali da stemperare il problema ed il prezzo proposto sembra in linea con le attese. Si tratta di una architettura nuova che mira a supportare implementazioni grafiche futuristiche e futuribili ed ad offrire prestazioni nei titoli correnti almeno competitive con Nvidia nella fascia media e medio-alta ) alle risoluzioni superiori che interessano agli appassionati (è stata utilizzata l’espressione ‘trading blows with a 1080’. Vega oggi è sicuramente (ed ovviamente) l’architettura grafica più avanzata disponibile sul mercato consumer, ma bisogna vedere che impatto reale avranno molte delle sue innovazioni, prima fra tutte il Primitive Shader ed il supporto per API alternative a DX11.

Resta il fatto che questo è un momento davvero carico di aspettative ed eccitante per ogni appassionato. Nvidia non ha più lo stesso monumentale vantaggio dei tempi di Kepler e Maxwell, e questo è un bene per tutti noi, perché al minimo porterà ad una lotta dei prezzi nella fascia davvero più rilevante per il mercato delle schede video, ovvero quello sotto i 500€. Ed è in questa fascia di prezzo dove non tanto la RX Vega 64, quanto la 56 potrebbe riservare grandi sorprese e soddisfazioni ad un prezzo di circa 430€ (calcolando il cambio, l’IVA e l’obolo alla Repubblica). Adesso più che mai è fondamentale aspettare rilevazioni indipendenti, ma possiamo ben sperare.

Presto potremmo ritenere un PC con 8 core e con una scheda video con 12.5 Miliardi di transistor come una cosa mainstream. Non è questo forse il miglior mondo possibile?

3 commenti su “Nell’orbita di Vega – Analisi delle nuove tecnologie e caratteristiche”

Monumentale vantaggio?

????????????????????

Anche Vega FE ha solo 2 stack, la differenza è che sulla RX usano gli stack da 4GB mentre sulla FE da 8GB con la stessa banda e stesso interface (2048-bit).

Hai perfettamente ragione, abbiamo provveduto alla correzione. Grazie!